Каждый вебмастер мечтает попасть на вершину поисковой выдачи. Пробив заветные позиции первой десятки площадок, многие сайты сталкиваются с очередными трудностями в продвижении. Опытные сеошники полагают, что проблема в сильной конкуренции на вершине поисковой выдачи. Иван Боговик из Marketinghack считает, что причины трудностей с органическим трафиком и продвижением внутри топ-10 Google абсолютно другие. В рамках очередной конференции по продвижению на западных рынках NaZapad 14 он поделился своими фишками продвижения сайтов внутри топ-10 Google для белых ниш.

Разделим доклад на две части. В первой мы разберем популярные ошибки, которые выбивают площадки из топ-10. Во второй поговорим об Е-А-Т и авторстве. На десерт вас ждет полезная информация про сниппеты и линкбилдинг.

5 ошибок на сайте, влияющих на продвижение

Разберем самые популярные и критичные ошибки, которые блокируют продвижение сайта.

Проблемы со структурой и перелинковкой

Обычно структура сайта отсутствует полностью или построена вокруг категорий и административных страниц «about us».

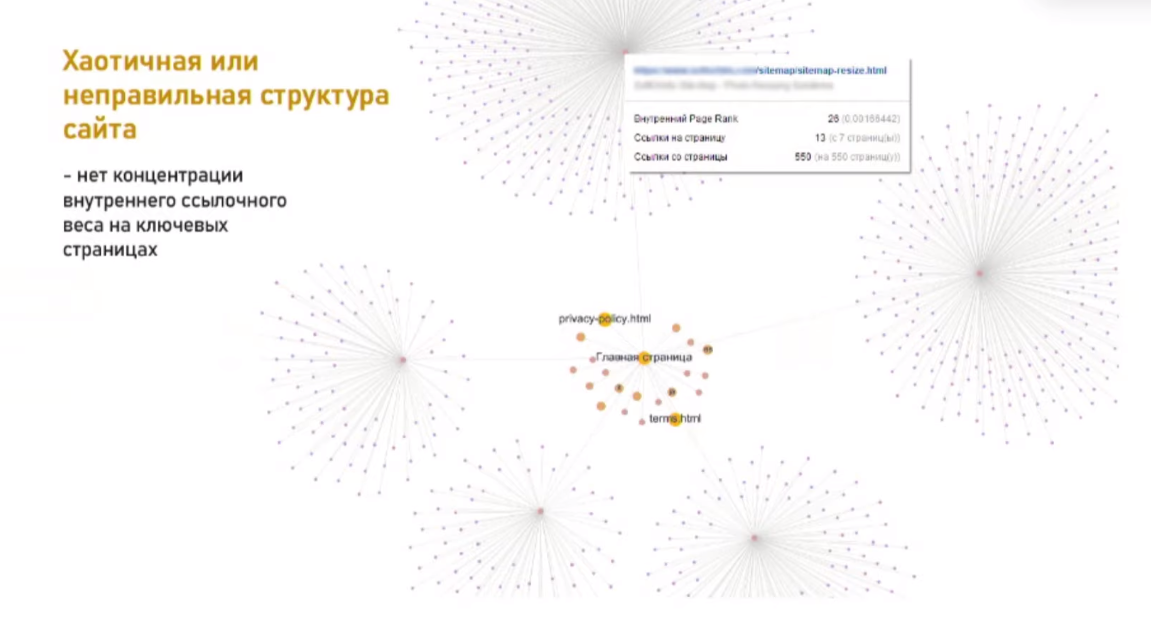

На примере ниже — скриншот WebSite Auditor для площадки клиента. Визуально все хорошо. Существует несколько веток, каждая из которых хорошо продвигается. На первый взгляд. Начинаем копать глубже и находим проблему. На самом деле — это страницы sitemap’ы, которые забирают львиную долю внутреннего ссылочного веса. Главная страница хорошо прокачана линками. Проблема в том, что она не монетизирована. Это не лендинг, а просто распределитель. У клиента продуктовый сайт и основные страницы — это сервисы. Получается, что все ссылки распределены между главной бессмысленной страницей, административными страницами типа «about apps», «privacy policy» и sitemap’ами. Когда сайт достигнет предела своих возможностей, он остановится. Эта структура не позволит ему конкурировать в топ-10. Владелец может бесконечно переписывать контент и поливать площадку ссылками. Проблема кроется в перелинковке.

Какая структура сайта будет эффективной?

Разберем два основных типа эффективной структуры площадки. Первая — концентрируем вес на главной монетизируемой странице. Это идеальная структура для сайта превьюшника с небольшой семантикой. Мы превращаем главную страницу в альфа-страницу, еще ее называют хаб, и качаем под высокочастотный или среднечастотный запрос. Бета-страницы отдают вес на главную и прокачиваются под низкочастотники. У структуры огромный плюс. Если подобрать правильный домен с ключевым словом, можно легко загнать в топ главную страницу. Минусы тоже есть. Их три:

- Структуру нельзя использовать для сайтов с широкой семантикой. Главную страницу не заточишь под большое семантическое ядро;

- За ключевое слово в домене можно выхватить переспам фильтра google;

- Сложности с добычей ссылок на главную страницу. Подобные линки активно удаляют на форумах, редите, комьюнити.

Вторую структуру продвигать сложнее, но в перспективе она более эффективна. В этом случае мы концентрируем ссылочный вес не на главной странице, а на отдельных альфа-страницах, то есть, на хабах. Homepage и бета-страницы отдают ссылочный вес альфа-страницам. В этом случае homepage будет у нас распределителем. Главный минус в том, что нужно прокачивать каждую альфа-страницу отдельно, а это затратно по времени.

Страницы-дубли

Об этой тривиальной ошибке говорят последние 10 лет. Она особенно характерна для площадок на wordpress. Малейшие изменения на сайте и движок плодит дубли. Wordpress любит из одного комментария cделать отдельную страницу. Избежать этого поможет небольшой чек-лист:

- Регулярная проверка для сайтов на wordpress любыми инструментами;

- Абсолютно все http страницы должны редиректить на https;

- Страницы с www должны редиректить на без www;

- Выявляем страницы-дубли комментариев и делаем 301-й редирект на основную нашу страницу или прописываем rel=”canonical”.

Битые ссылки

У каждого сайта, рано или поздно, появятся внешние битые ссылки. Они не наносят большого вреда площадке. Внутренние битые ссылки гораздо опаснее. Они ухудшают поведенческие факторы площадки. Пользователь переходит на страницу, а ее нет. Обнаружить такие линки легко с помощью Google Search Console, Ahrefs, Yoast seo, Screaming Frog, Netpeak Spider или любым другим WP SEO плагином.

Thin content и страницы, не приносящие трафик

В рунете распространено мнение, что к thin content относятся только страницы, где мало контента или копипаста. Однако, это не полный список. Представьте, что вы заказали у индусов 50 статей по $2. Они быстренько их штампуют по одному шаблону, а вы размещаете контент на сайте. Подобные материалы Google отменит, как контент низкого качества. Как правило, такие страницы быстро перестают приносить органический трафик или изначально его не приносят и никогда не будут.

Также к thin content относятся материалы, содержащие часть контента другой вашей страницы с ссылкой на нее. Многие агрегаторы грешат подобным. Лечение простое. Выявляем страницы, которые не приносят трафика с помощью Google Search Console или Ahrefs, дорабатываем и актуализируем информацию либо удаляем материал. Последним пользуемся в случае, если страницы повторяются и происходит каннибализации ключей. Прописываем 301-й редирект на более релевантную страницу, чтобы одна страница не отжирала поисковые запросы у другой. Также удаляем страницы, которые не принесли трафика за последний месяц.

В случае релевантного контента и сайту первой структуры, есть смысл на главную залинковать 301-м редиректом, это будет нормально работать.

В случае релевантного контента и сайту первой структуры, есть смысл на главную залинковать 301-м редиректом, это будет нормально работать.

Устаревший контент

До вершин поисковой выдачи чаще всего добираются уже немолодые площадки, а значит устаревший контент становится актуальной проблемой. Какие материалы следует обновлять?

- Материалы о уже несуществующих продуктов и сервисов;

- Материалы, потерявшие свою актуальность;

- Материалы, которые скопипастили другие площадки. Копируем фрагмент текста в кавычки на стыке предложений, вставляем, и кидаем в Google. В поисковой выдаче проверяем позиции по этому запросу. Если ваш сайт не первый, а второй, третий или еще ниже — это плохо. Значит контент своровали, и Google отдал приоритет другой площадке. Материал срочно нужно переписывать.

Значение Е-А-Т для продвижения

E-A-T — экспертность, авторитетность, доверие. Этот принцип несколько лет был главным в оценке контента асессорами Google. 16 мая 2019 года поисковик выпустил обновленное руководство по оценке качества, и принцип E-A-T в нем сменил Page quality. Теперь он стал главным критерием оценки, а E-A-T остался только как его часть. Рассмотрим пример сайта на скриншоте ниже. С помощью сервиса Barracuda накладываем органический трафик сайта на все апдейты Google. Это помогает понимать как они влияют на площадку. В центре графика огромная просадка — ребята восстанавливали бэкап. Смотрим дальше, там уже интереснее. В мае вышел очередной апдейт гугл и органический трафик резко пошел вниз. Причины две: устаревший контент и проблемы с Е-А-Т. Авторство для статей было указано довольно халтурно. То есть просто в конце статьи имя и фамилия автора. Google не посчитал его экспертом в нише и срезал трафик материалу.

А это график того же сайта в марте 2019 года, когда вышел очередной апдейт Google. Он тоже уронил планку органического трафика. До мартовского апдейта все было +\- нормально, а потом рывок вниз и плавное падение.

Каждый год Google методично срезал органический трафик площадки после каждого апдейта. В мае 2020 года провал с 600 уников в сутки до 400.

А в марте 2019 с 1200 до 600 уникальных посетителей в сутки.

Спустя некоторое время картина еще печальнее. Провал до 200 уникальных посетителей в сутки после майского апдейта в 2020 году.

А запустил эту катастрофу новинки в механиках Google в марте 2019.

Как получилось так, что за два года из 1 200 уников осталось 200? У клиента продуктовый сайт. Авторства у материалов либо не было, либо оно было указано в форме имя/фамилия в конце статьи. У Google нет уверенности, что этому контенту можно доверять.

Как делать авторство для сайтов с учетом Е-А-Т

Существует два основных способа: создать своего автора или нанять автора-эксперта. Разберем тонкости каждого пути. Когда мы создаем своего автора, то его недостаточно просто зарегистрировать в соцсетях (Linkedin, Twitter, Facebook). В них постоянно нужно публиковать материалы, которые будут подтверждать экспертизу в нише: делиться новостями, публиковать свое мнение, добавлять в друзья других экспертов в теме. Обязательно размещаем посты на профильных форумах и коммьюнити своей ниши. Идеально иметь публикации статей на авторитетных сайтах. Тогда есть шанс, что вы убережете себя от «гугловского глаза».

Второй способ — нанять автора-эксперта. В этом случае может возникнуть масса сложностей. Первое — договориться с настоящими экспертами непросто. Второе — это дорого. Иногда очень дорого: $1 000 за статью в 2 000-2 500 слов. Если постараться, то можно найти $250. Но и это не все. Вы даете эксперту конкретное техническое задание. Например, планы с LSI-словами для каждого раздела в серьезных статьях, но авторы иногда забивают на них. Несмотря на эти 3 нюанса, автор-эксперт — идеальный метод для YMYL-сайтов

Значение CTR для продвижения

Чем выше позиция в выдаче, тем выше кликабельность. И наоборот. Повышение CTR приводит к повышению позиций. Некоторые маркетологи считают это мифом, график ниже показывает, что они неправы. Можно увидеть корреляцию CTR и поисковых позиций за июль 2019 года. Из этого следует один вывод — повышаем кликабельность.

Один из самых простых и эффективных способов ㅡ оптимизация сниппетов страниц. Работаем с мета-описаниями и мета-тайтлами. Анализируем сниппеты страниц-конкурентов в топ-10 Google и придумываем собственный, еще более привлекательный. Создаем несколько вариантов и тестируем заголовки на результативность. Оставляем заголовок, показавший лучшие результаты.

В WordPress можно автоматически проводить А/В тестирование заголовков с помощью плагина headline optimizer. Забиваете в него контрольный мета-тайтл и дополнительный, а система самостоятельно меняет их для каждой группы юзеров.

Ссылки для сайтов в топ-10

Сразу ответим на главный вопрос. Есть ли смысл наваливать сотни ссылок? И да, и нет. Зависит от конкретной ситуации на конкретной площадке. Например, есть конкуренты с трастовым сайтом, у которого 150-200 ссылок в топе и классный контент. Площадка за счет траста очень хорошо котируется, но если бы ребята поработали над ссылками, то топ-1 можно занять на очень долгое время. Всегда старайтесь прокачивать ссылками страницы, занимающие высокие позиции в поисковой выдаче по целевому запросу. Подобные линки самые эффективные. Представьте, что ваша площадка на 9 месте в поисковой выдаче. Вам удалось получить 10 ссылок с сайта из топ-3. Размещаете их на своих самых популярных страницах и ваша площадка залетит в топ-5.

Разберем методику подробнее. Получить ссылки можно двумя способами: создать страницы-конкуренты с линками или аутрич. Во втором случае договориться с популярными площадками будет очень сложно. Следует начинать писать тем, кто на 4 или 5 позиции в поисковой выдаче. При размещении ссылки важен правильный анкор. Он обязательно должен включать в себя поисковой запрос. Если договориться с конкурентами не получилось, создаем страницы-конкуренты на авторитетном трастовом сайте с dofollow ссылками.

Также используем продвижение Tier 2 ссылками. Контент на страницах, где вы их размещаете, должен быть очень хорошим и не менее 2 000-3 000 слов. Как можно получить Tier 2 ссылки? Легко. Используем социальные сети, линки в коммьюнити, сайты-опросники, форумы, бесплатный гостевой постинг и платный гостевой постинг, в том случае, если цены в пределах $50 за публикацию своего контента.

Многие игнорируют пассивные методы получения ссылок. Однако англоязычные seoшнику уделяют этому способу огромное внимание. И не зря. Можно зоздавать кучу бесплатных ссылок с уникальных доменов. Благодаря им ваша площадка выглядит гораздо реалистичнее и защищена от Google Penguin. Основных методов получения ссылок три:

- Создание бесплатного онлайн-продукта на сайте: книга, гайд, шаблон, иконка или аудиокнига. В дальнейшем пользователи сами его распространяют, а мы получаем настоящий крауд-маркетинг;

- Создание бесплатного онлайн-сервиса. Это может быть калькулятор, конвертер музыки, проверка текста и подобное. Написать такую программку несложно. Простейший скрипт. Пользователи будут ссылаться на ваш сервис, на страницы которого можно сделать линки на ваши хабы;

- Создание графики: инфографика, диаграммы и схемы. Берем актуальную тему, о которой бурлит интернет, собираем статистику и вешаем на сайт график. Другие площадки с радостью разместят подобное у себя на странице с указанием авторства.

Вывод

Попасть на вершину поисковой выдачи трудно. Еще сложнее там удержаться и продвигать свой сайт выше. Стройте правильную структуру сайта, исправляйте ошибки и занимайтесь линкбилдингом. Только в этом случае у вас есть все шансы побороться за места на первых позициях поисковой выдачи.

Не забывайте подписаться на наши Телеграм-каналы: основной канал, e-commerce, гемблинг, адалт и дейтинг, беттинг, финансы и классический манимейкинг.